L’intelligenza artificiale (AI) ha il potenziale per rivoluzionare la nostra società. Tuttavia, gli algoritmi AI possono amplificare i bias di genere presenti nei dati di addestramento.

Questo articolo si propone di esaminare il rapporto tra AI e pregiudizi di genere, delineando strategie per implementare algoritmi etici e responsabili.

L’AI amplifica i bias di genere?

I bias di genere sono preconcetti e stereotipi associati a determinati generi. Questi pregiudizi influenzano il modo in cui si pensa, si agisce e si prendono decisioni nella vita quotidiana.

I bias di genere sono amplificati dall’AI attraverso:

- I dati: i sistemi sono alimentati da dati che spesso riflettono e amplificano i pregiudizi presenti nella società. Per esempio, molti sistemi di traduzione associano al maschile specifiche categoria professionali (come medico o ingegnere), discriminando le donne che lavorano nel medesimo ruolo.

- Gli algoritmi: gli algoritmi di intelligenza artificiale possono essere progettati in modo da incorporare stereotipi di genere. Ad esempio, un chatbot inclusivo deve essere sviluppato prestando particolare attenzione all’uso corretto dei pronomi, prediligendo l’uso di un pronome impersonale.

Machine Learning: addestramento e discriminazione

La machine learning è un campo dell’AI che si occupa dello sviluppo di algoritmi in grado di apprendere dai dati. Il processo di machine learning si articola in tre fasi:

- Addestramento: il modello viene esposto a un insieme di dati di addestramento per imparare pattern o relazioni tra le variabili.

- Validazione: il modello viene valutato utilizzando un insieme di dati di validazione separato, per determinare quanto bene generalizza ciò che ha imparato.

- Test: il modello viene testato su un set di dati completamente separato (il set di test) per valutare le sue prestazioni in condizioni reali e misurare la sua capacità di generalizzazione.

Un esempio

Esempio di machine learning addestrata con dati discriminatori emerge in America nell’ambito del riconoscimento facciale. I dati di addestramento erano predominati da informazioni caratteriali di uomini bianchi.

L’utilizzo di questo campionamento di dati sbilanciati e non rappresentativi ha portato a risultati preoccupanti. Durante i test in cui è stato richiesto al software di riconoscere più di mille volti sono emersi errori discriminatori significativi. Si è osservata un’identificazione inaccurata per le persone appartenenti a gruppi minoritari o per le donne con pelle scura.

La tecnologia è un prodotto umano e l’uomo, di conseguenza, deve scegliere attentamente quali dati di addestramento dare in pasto alla machine learning.

Conseguenze

L’AI, amplificando i pregiudizi di genere, porta a conseguenze negative come:

- Discriminazione e disuguaglianza sociale

- Perpetuazione degli stereotipi di genere

- Esclusione delle minoranze

Machine learning: algoritmi etici e responsabili

Contrastare i bias di genere nell’intelligenza artificiale richiede sforzi sia nella fase di addestramento degli algoritmi che nell’aggregazione e nella pulizia dei dati utilizzati.

Bisogna essere consapevoli dei pregiudizi di genere e dei loro potenziali impatti. È fondamentale lavorare attivamente durante ogni fase del processo di sviluppo per creare sistemi responsabili ed inclusivi.

Grazie ai seguenti interventi è possibile implementare algoritmi che siano etici e responsabili:

- Promuovere l’educazione e la consapevolezza sull’AI e sui bias di genere

- Analizzare i dati per individuare e mitigare i bias

- Progettare e sviluppare algoritmi equi

- Favorire la diversità e l’Inclusione nelle equipe di sviluppo

Un esempio

Google ha adottato un approccio centrato sulla persona. AutoML (di Google) è un esempio di machine learning addestrata con dati basati sul benessere comune e l’utilizzo responsabile e inclusivo dell’AI. Lo scopo è quello di attenuare i pregiudizi preesistenti che plasmano e influenzano quotidianamente la vita delle persone.

Qualora il modello standard di AutoML non soddisfi le esigenze specifiche di un utente, è possibile creare un modello personalizzato che includa tutte le caratteristiche necessarie.

AI e bias di genere: parliamone insieme

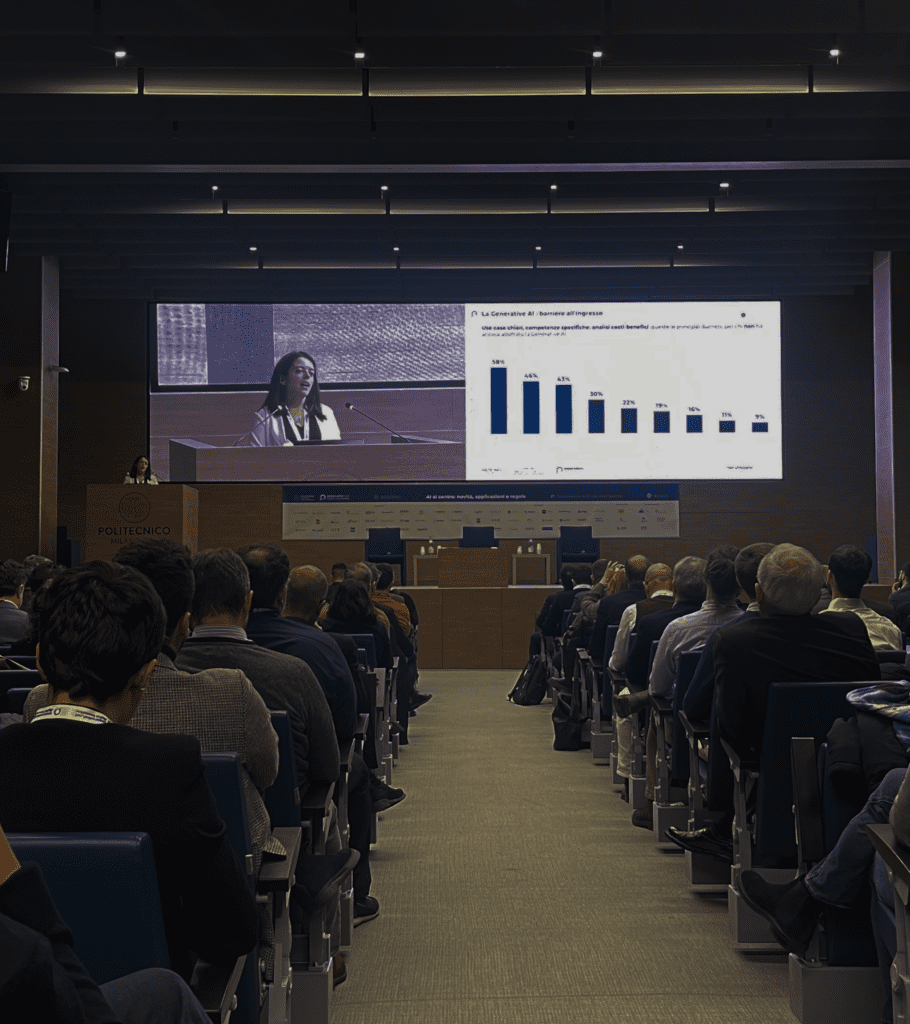

Il 20 febbraio a Milano Luiss Hub si terrà l’evento di networking “Algoritmi e pregiudizi: esplorando i bias nell’intelligenza artificiale” organizzato da Fondazione Giacomo Brodolini e Digital Innovation Days, in occasione della chiusura dell’Osservatorio per il lavoro sostenibile Future of Workers.

Un’ottima occasione per approfondire il tema dell’intelligenza artificiale in ottica di parità di genere, esplorando come si comporta e ovvia (e se lo fa) i bias.

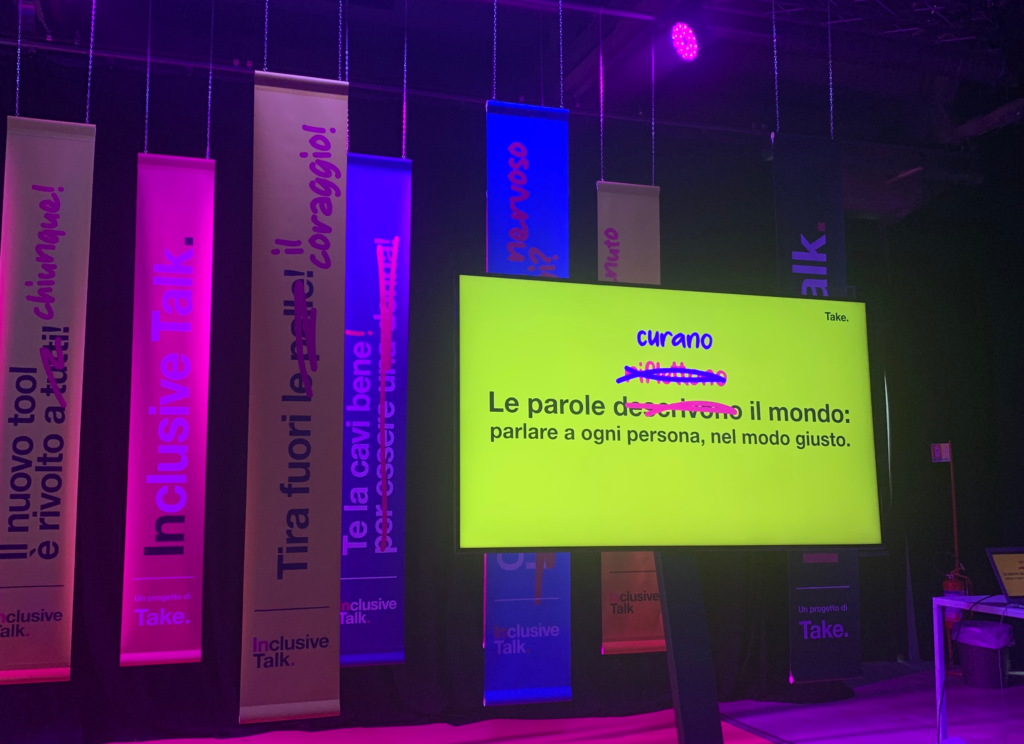

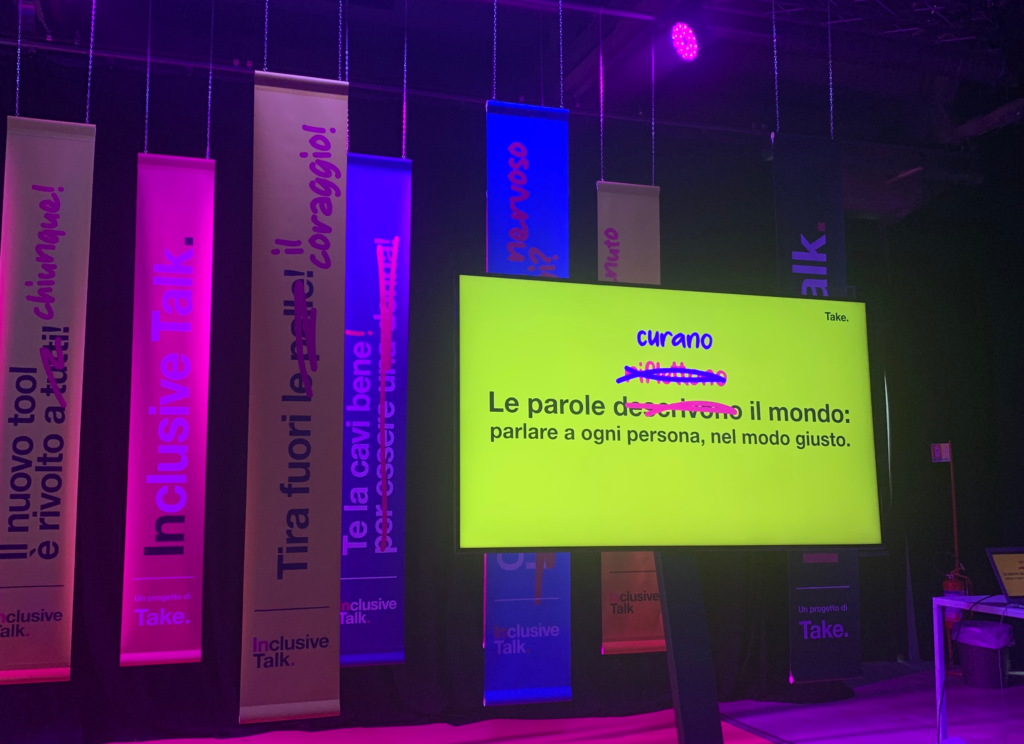

All’evento sarà possibile conoscere nel dettaglio il progetto “Inclusive Talk“, un tool AI-based ideato e sviluppato da TakeGroup.

L’evento è aperto a tutti. Per partecipare, è necessario registrarsi gratuitamente al seguente link.

Conclusione

Il futuro dell’intelligenza dipenderà da come sceglieremo di svilupparla e utilizzarla. Se ci impegniamo a contrastare i bias di genere, l’AI può essere una forza potente per la parità di genere e la giustizia sociale.